GTX1080Ti:浮点运算大揭秘,游戏与科学如何双赢?

NVIDIA公司研发的GTX1080Ti,因其高性能浮点运算能力广受瞩目。浮点运算作为计算机重要的数值计算手段,用于实数处理领域。由于其出色的浮点运算潜能,GTX1080Ti在图像处理以及科学数值模拟等领域得到了广泛应用。

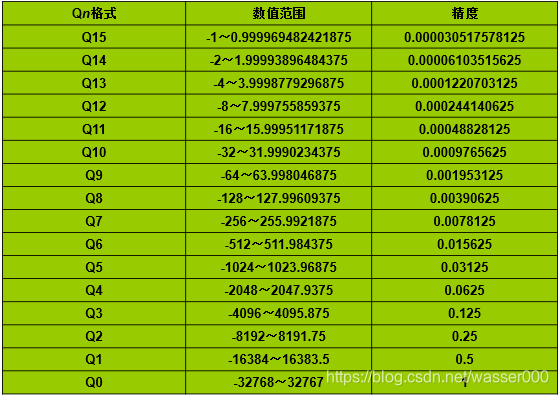

在当今电脑体系中,浮点运算主要被划分为单精度与双精度两类。前者占用32位内存,后者则需64位空间。作为具备卓越浮点运算实力的GTX1080Ti显卡,其不仅能达到惊人的11.3TFLOPS单精度处理速度,还可提供0.35TFLOPS的双精度运算能力,因此深受专业人员及游戏爱好者青睐。

2.浮点运算与图形处理

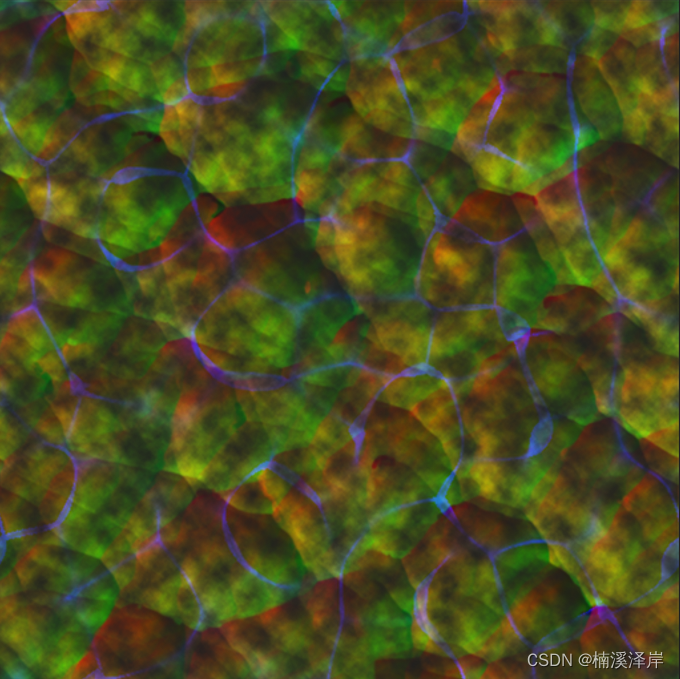

在图形图像处理方面,浮点运算具有至关重要的地位。其需要大量数学运算以达成如光照、阴影及纹理映射等视觉效果。得益于GTX1080Ti卓越的浮点运算能力,可迅速有效地执行此类复杂计算,进而展现更为真实、流畅的画面效果。

单精度与双精度浮点数分别适用于不同的图形处理需求。前者在图像渲染及纹理坐标计算中广泛使用,后者更适合物理模拟以及精准度要求较高的射线追踪环节。搭载了GTX1080Ti显卡的平台,对二者均有良好的处理能力,为图形处理带来了坚实后盾。

3.浮点运算与深度学习

鉴于深度学习需求的不断提高,对浮点运算的要求亦相应提升。深度学习中的大数据矩阵乘法与激活函数计算等复杂操作,均需强有力的浮点算力支持。显卡中的翘楚——GTX1080Ti,因其卓绝性能,在深度学习领域备受青睐。

TensorFlow与PyTorch等深度学习框架能充分发挥GTX1080Ti的浮点处理能力,加速神经网络模型的训练及推理环节。使用GPU并行计算,深度学习任务的完成速度可明显提升,模型训练效率也相应提高。

4.浮点运算与科学计算

除图形处理与深度学习外,科学计算同样需求强大的浮点运算能力。此领域常常需要执行繁琐的数值计算及仿真任务,如大规模矩阵运算以及微分方程求解等操作。

1080Ti,这支卓越的通用显卡,对科学计算的领域来说,具有不可忽视的重要作用。借助它卓越的浮点运算能力,科研工作者能有效地提升科学模拟实验和数据分析的速度,从而大大提高工作效率,进一步推动研究成果的发展。

5.浮点运算优化技术

以GTX1080Ti浮点运算效能的提升为焦点,优化应用程序性能显得至关重要。借助一系列优化手段,开发者有望挖掘并有效运用显卡的计算潜力,从而实现更高效、迅捷的计算过程。

采用CUDA编程模型实现并行处理,优化内存读取方式以节省通信时间,甄选适当的数据格式以缩减储存空间成本等策略是扩展GTX1080Ti在浮点运算领域潜能的常见手段。根据实际应用环境进行深度优化,能使其性能得到最大程度的释放。

6.浮点运算误差与稳定性

在实施规模较大且精度要求较高的数值运算过程中,保持误差控制和计算稳定性至关重要。然而,由于浮点数的表示能力有限,大规模计算往往会引发舍入误差及截断误差等问题。此类误差极易造成计算结果与实际值间的显著偏差,从而影响数据精确度。

面对以上挑战,研发团队需运用优化的数值稳健检测手段与误差管控策略,确保程序在完成高度复杂的数值运算过程时,能保证结果的稳定性及精准度。此外,在实际操作环节,亦应依据特定环境制定适宜精度标准并选择最佳优化策略,以此权衡计算精确度与效率的衡量关系。

7.浮点运算在游戏领域中的应用

除专业范围之外,浮点运算技术亦广泛运用于游戏行业。诸如物理仿真、碰撞检测及光影效果等复杂而实时的游戏开发任务,皆依赖于高效而强大的浮点运算技术支持。

以高性能著称的GTX1080Ti显卡,为广大游戏爱好者所钟情。其卓越的单精度处理能力,使游戏图像呈现更为细腻、亮丽,并支持更丰富的细节与特效,提供沉浸式的游戏体验。

8.总结与展望

GTX1080Ti显卡凭借卓越的浮点运算能力,未来将广泛渗透至图形处理、深度学习、科学计算及游戏等多个领域,预计仍将在科技创新的推动下,发挥日益重要的角色,提高用户体验。