GTX1050Ti显卡:游戏之选还是AI黑洞?

1.GTX1050Ti显卡概述

NVIDIA的GTX1050Ti为一款搭载Pascal架构的中高端显卡,配备GDDR5显存及768个CUDA核心,在游戏性能方面表现卓越,广泛运用于电子竞技与图形设计等领域。然而,针对人工智能(AI)任务,该显卡性能是否足以胜任?本文将对此进行深度剖析。

2.人工智能与显卡需求

人工智能作为一个热门领域,包括机器学习、深度学习、神经网络等尖端技术。在此类应用中,大容量计算资源以及高性能CPU处理大规模数据及复杂运算显得尤其关键。然而,GPU——以其卓越的并行计算能力——在人工智能领域内起着举足轻重的作用,它能有效地提升深度学习训练与推理速度。

3.GTX1050Ti在AI任务中的表现

作为定位中高市场、实用于图形任务的GTX1050Ti,尽管表现优异,然而却在深度学习等繁杂AI运算过程中遇到了挑战。这主要归因于其相对有限的CUDA核心数以及缺乏针对深度学习的Tensor核心,使得其在应对大规模神经网络时,性能可能无法达到预期效果。

4.AI框架对显卡性能要求

选配合适的显卡以应对AI应用需求时需审慎考虑AI框架的特殊特性。举例而言,TensorFlow以其更倾向于CUDA核心数的需求而闻名;相比之下,PyTorch则更看重单核性能。根据各框架的特性进行合理的显卡挑选,将有助于提升AI任务的执行效率。

5.GTX1050Ti适用的AI场景

尽管GTX1050Ti在处理大型神经网络方面略显不足,然而在一些轻度或者中型AI情境中的应用仍有其独特优势。比如,在图像识别、语音处理以及自然语言处理等领域,GTX1050Ti均能应对自如,且具有较高的性价比。

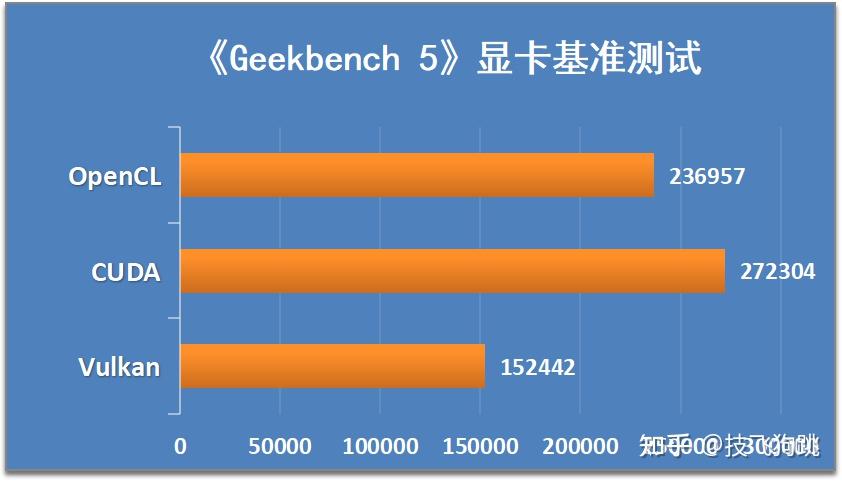

6.提升GTX1050Ti在AI上的性能

尽管GTX1050Ti在AI应用中的性能稍显不足,然而,仍有途径可提升其性能。例如,依靠CUDA加速库进行优化、调整深度学习模型架构或降低精度要求等策略均能有效提高其在AI任务中的表现。

7.考虑其他替代方案

若需求急切,预算充足,用户可选配更适宜执行AI任务的高端显卡,例如NVIDIA的RTX系列和Titan系列,它们能显著提升复杂神经网络的处理性能。

8.结语

根据上述分析,GTX1050Ti虽定位为中高端显卡,然而其对轻量级或者中小规模的AI任务具有一定处理能力,然于大规模神经网络等复杂运算仍显不足。因此,面对AI领域显卡选型时,应依据实际需求与预算进行合理配置,同时兼顾多重考量以选出最符合自身需求之产品。